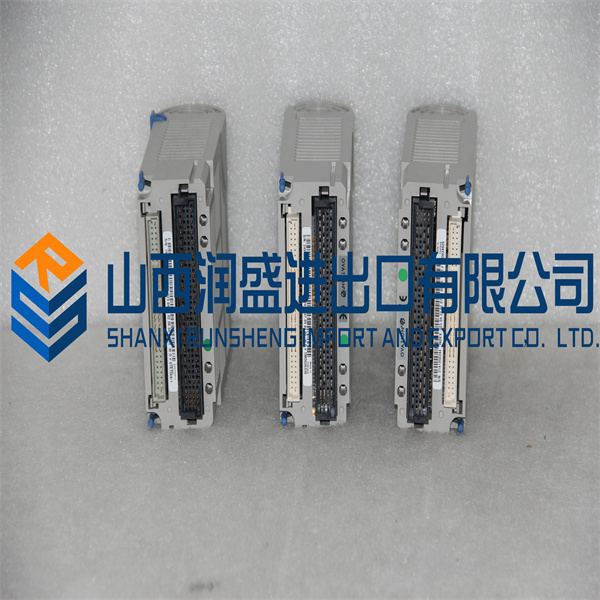

CP60 FOXBORO

能够大大降低能耗或是加快速度的类脑的处理器对于实现更高水平的智能无疑会有很大的帮助,但要真正实现类人水平的通用人工智能,除了需要这样的硬件基础外,关键还需要理解生物脑对于信息所做的计算,即类脑的处理及学习算法。对于此研究方向,一个常见的顾虑是:现在神经科学对于大脑工作机制的了解还远远不够,这样是否能够开展有效的类脑算法研究?对此,我们可以从现在获得广泛成功的深度神经网络获得一些启示。从神经元的连接模式到训练规则等很多方面看,深度神经网络距离真实的脑网络还有相当距离,但它在本质上借鉴了脑网络的多层结构(即“深度”一词的来源),而大脑中,特别是视觉通路的多层、分步处理结构是神经科学中早已获得的基本知识。这说明,我们并不需要完全了解了脑的工作原理之后才能研究类脑的算法。相反,真正具有启发意义的,很可能是相对基本的原则。这些原则,有的可能已经为脑科学家所知晓,而有的可能还尚待发现,而每一项基本原则的阐明及其成功的运用于人工信息处理系统,都可能带来类脑计算研究的或大或小的进步。非常重要的是,这一不断发现、转化的过程不仅能促进人工智能的进展,也会同步加深我们对于大脑为何能如此高效进行信息处理这一问题的理解[6],从而形成一个脑科学和人工智能技术相互促进的良性循环。

脑中除了基本的兴奋与抑制性的神经递质外,还有众多的神经调质,他们的作用在于根据当前的环境与行为目标随时动态调节大范围神经网络的行为,使得相对固定的网络结构能够胜任复杂多变的情况,实现千差万别的任务。近年来对于介观及宏观脑网络动态活动规律的研究发现,脑网络可能自发地组织于一个“临界”状态附近,这一状态使得信息的存储、传递和处理都能实现最优化[10]。重要的是,通过对这一状态的微调,可以迅速调节网络功能,从而适应不同任务的要求。对于神经调质以及网络状态调控等原理的借鉴,有望对设计更加灵活,更有适应能力的人工信息处理系统提供有益启示。我们有可能从大脑的工作原理受到重要启发的第3个例子是如何实现小样本的学习和有效推广。目前取得巨大成功的深度学习依赖于庞大的样本数量,这与大脑卓越的“举一反三”,即小样本学习的能力形成鲜明对比[11]。原理上看,这意味着生物脑的学习过程并非从零开始,而是从学习之初,就拥有并运用了重要的先验知识,这包含了物种在进化过程中学到的(生物学称之为系统发生),以及个体在生活过程中学到的有关真实世界的关键知识[12]。读取这些知识,以及借鉴如何将这些知识作为先验信息注入神经网络结构从而实现小样本学习,可能会是神经科学以及类脑算法设计中一个富于成果的领域。 除了上面举出的几个例子,神经科学可能会对类脑算法设计提供重要启示的领域还包括对于突触可塑性的进一步认识,具体的各项脑功能在神经环路水平的机制等。几乎可以说,每一项脑科学的原理性发现,都可能蕴含着一颗种子,有潜力在人工智能的领域成长为像深度神经网络一样的参天大树。

MAGNETEK DRIVES JUSP-RG08A REGEN UNIT 60W 50OHM

MAGNETEK DRIVES JUSP-RGO8 REGEN UNIT 60W 50OHM

MAGNETEK DRIVES JUSP-RGO8A REGEN UNIT 60W 50OHM

MAGNETEK DRIVES JUSP-TA36P CONNECTOR TERMINAL BLOCK CONVERSION UNIT

MAGNETEK DRIVES JUSPTA50P CONNECTOR

MAGNETEK DRIVES JUST-DCP60A POWER SUPPLY

MAGNETEK DRIVES JV0P110 DRIVE

MAGNETEK DRIVES JVOP-100 KEYPAD DIGITAL OPERATOR

MAGNETEK DRIVES JVOP-114 OPERATOR INTERFACE FOR VARISPEED 606 PC3 DIGITAL

MAGNETEK DRIVES JVOP-130P OPERATOR DIGITAL